Autores: Andrea Rincón G. Médica Familiar. MSc Salud Pública. M.Sc.(c) Big Data Sanitario. Miembro Tanque de Pensamiento AIpocrates. – Daniel Muñoz Ingeniero Electrònico Customer Engineer de GOOGLE. M.Sc.(c) Ciencia de datos. Autor invitado

Si recorremos los pasillos de los congresos más influyentes de tecnología sanitaria, como la reunión anual de la Radiological Society of North America (RSNA) o el HIMSS Global Health Conference, notaremos un cambio sutil pero profundo en la narrativa de innovación. Hace cinco años, el símbolo de estatus para una institución de salud de vanguardia era ser un «Early Adopter» de soluciones de IA.

El estándar de prestigio ha sufrido un desplazamiento alarmante. Actualmente, el verdadero símbolo de “status”, debatido en las altas esferas y convertido en promesa corporativa, es la capacidad de decir: «Construimos nuestra propia Inteligencia Artificial«. Esta tendencia hacia el desarrollo in-house nace de un deseo legítimo de soberanía de datos y especificidad clínica, pero puede representar una falacia estratégica fundamental. Al intentar replicar infraestructuras de aprendizaje profundo que requieren economías de escala globales, los hospitales no están construyendo activos estratégicos; están acumulando pasivos operativos.

La estrategia económica

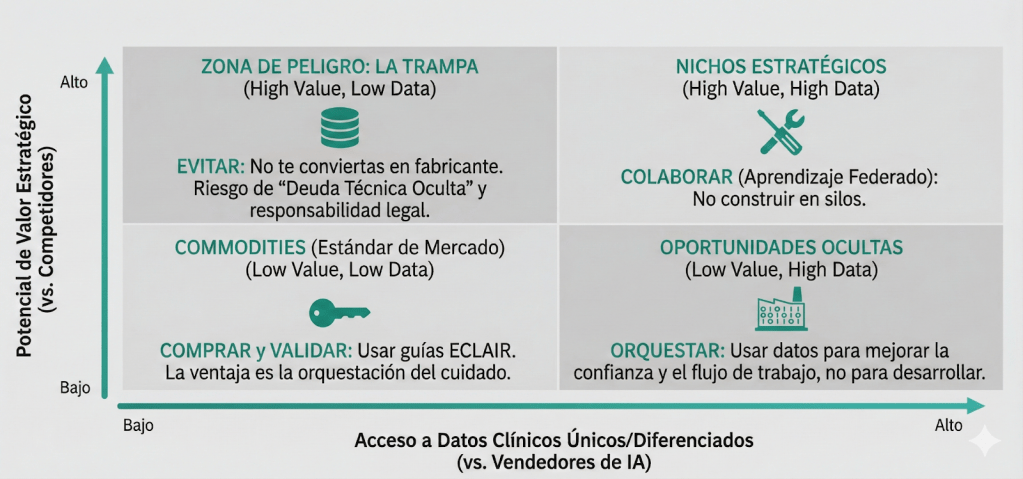

Antes de escribir una sola línea de código Python, es imperativo someter la decisión de construir al rigor de la estrategia de negocios. Según el análisis del Boston Consulting Group (BCG) sobre el dilema «Build vs. Buy», como se resume en la figura 1, una organización sólo debe internalizar el desarrollo de tecnología cuando esta constituye una ventaja competitiva propietaria y única que el mercado no puede ofrecer.

¿Es un modelo de segmentación de nódulos pulmonares una ventaja competitiva única de un hospital? La respuesta objetiva es no. Es un commodity de rápida maduración. La verdadera ventaja competitiva de un hospital reside en la orquestación del cuidado y la confianza del paciente.

Figura 1. Matriz de decisión estratégica para hospitales. Adaptación Boston Consulting Group (2018).

El error financiero más común es confundir el costo de desarrollo con el costo de propiedad. Los hospitales pueden aprobar presupuestos de capital para contratar científicos de datos, ignorando el costo operativo perpetuo. Cada dólar gastado en mantener un servidor de entrenamiento es un recurso que no se invirtió en la validación clínica de las herramientas, contraviniendo la lógica de asignación eficiente de recursos en salud.

La realidad técnica

Incluso si la lógica económica se justificara, la realidad de la ingeniería de software presenta barreras a menudo insuperables para un equipo interno pequeño.

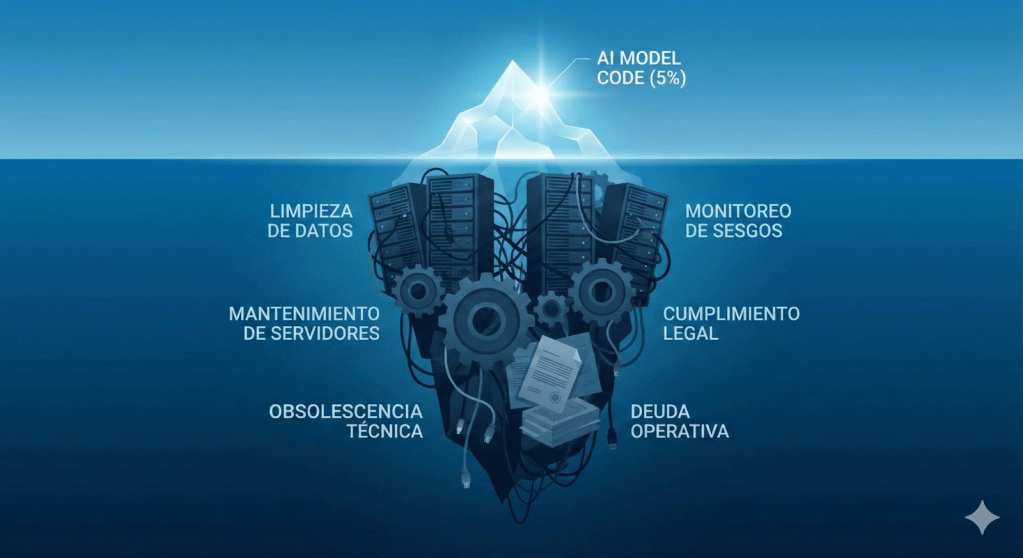

La lección fundamental sobre la realidad técnica fue establecida por ingenieros de Google Research. En un informe referente de la industria, Sculley et al. (2015) demostraron que el código del modelo —la parte visible— representa apenas el 5% del esfuerzo. Como se ilustra en la figura 2, el abrumador 95% restante se consume en la infraestructura y el monitoreo, validando el concepto de Deuda Técnica Oculta.

El problema, por lo tanto, no es el algoritmo, sino el costo perpetuo de mantener ese 95% de infraestructura invisible. Esta realidad ha llevado a la American Hospital Association (AHA), en su reporte de mercado de 2025, a emitir una advertencia directa a los directivos: «Los hospitales no deben construir una infraestructura de TI separada para la IA». Intentar gestionar un stack tecnológico paralelo y aislado para proyectos internos es una receta para la fragmentación y la obsolescencia técnica.

Figura 2. El iceberg de la deuda técnica. El código del modelo de IA (la punta visible) representa solo el 5% del esfuerzo total de un sistema funcional. El 95% restante —la infraestructura de datos, el monitoreo y el mantenimiento— es la «deuda técnica oculta» (Sculley et al., 2015).

La advertencia técnica más reciente de Google Research es aún más severa. En su estudio masivo sobre “underspecification” o subespecificación (D’Amour et al., 2022), demostraron que los modelos de aprendizaje profundo sufren de una fragilidad intrínseca: pueden mostrar métricas perfectas en el laboratorio durante el desarrollo in-house, pero comportarse de manera errática y peligrosa ante cambios menores en el entorno real.

Para un hospital, esto significa que un modelo construido internamente puede funcionar el lunes, pero fallar el martes simplemente porque se cambió la configuración de un ecógrafo. Solo los modelos comerciales con validación multicéntrica masiva logran mitigar este riesgo de subespecificación.

Complementando esto, diversos autores (Sambasivan et al. 2021). advierten sobre el fenómeno de las «Data Cascades« o cascadas de datos. Los equipos internos, a menudo presionados por tiempos de entrega rápidos, tienden a subestimar el trabajo sucio de la limpieza de datos. El resultado son modelos frágiles, entrenados con datos ruidosos, que no aprenden fisiopatología, sino que memorizan los sesgos de codificación y facturación de la institución.

La evidencia clínica

El argumento más seductor a favor del desarrollo interno es la especificidad: «Nuestros pacientes son únicos; necesitamos modelos entrenados con nuestra data local». Esta premisa choca frontalmente con la evidencia estadística.

Referentes académicos, como el estudio publicado en JAMA Internal Medicine sobre el modelo de sepsis de Epic Systems, han desmantelado el mito de la infalibilidad algorítmica. Se demostró que incluso las herramientas líderes sufren caídas drásticas en su rendimiento debido al dataset shift. Ante esto, surge una pregunta incómoda, si un gigante tecnológico no puede blindarse contra este fenómeno, ¿qué nos hace pensar que un equipo interno, limitado a silos de Small Data, tendrá mejor suerte?

Para agravar la situación, Rahimi et al, en una revisión sistemática publicada en 2024 en el Journal of Medical Internet Research, analizó más de 1,200 estudios sobre implementación de IA. Los autores concluyeron que el verdadero abismo no es tecnológico, sino de implementación.

De hospital a fabricante

La decisión de internalizar el desarrollo de IA introduce una capa de riesgo jurídico y ético que a menudo escapa al radar de la gobernanza corporativa tradicional. Desde una perspectiva legal, el hospital que despliega sus propios modelos asume la responsabilidad total del producto (product liability), una carga regulatoria para la cual sus equipos jurídicos rara vez están preparados. A diferencia de la práctica médica estándar, donde el error es humano y puntual, un error algorítmico es sistémico y escalable. Sin la infraestructura de validación y vigilancia postcomercialización que caracteriza a la industria de dispositivos médicos, la institución opera en una precariedad legal insostenible.

Simultáneamente, la dimensión ética presenta el riesgo de la caja negra institucional. Como evidenciaron Obermeyer et al. (2019) en Science, los sesgos algorítmicos pueden permanecer ocultos bajo métricas de eficiencia aparentes, discriminando a poblaciones vulnerables al confundir gasto en salud con complejidad clínica. Al prescindir de la validación externa, el hospital elimina los contrapesos necesarios para detectar estos fallos, transformando prejuicios históricos en políticas automatizadas de exclusión.

Validadores expertos (Guías ECLAIR)

Si construir conlleva riesgos evidentes, ¿la alternativa es comprar a ciegas? En absoluto. La respuesta científica ha escalado recientemente. Si bien las guías ECLAIR (Sociedad Europea de Radiología) marcaron el camino en 2021, el consenso se ha globalizado.

En 2024, las cinco sociedades de radiología más influyentes del mundo (incluyendo la norteamericana RSNA, la europea ESR y la canadiense CAR) emitieron una declaración histórica. Este documento conjunto (Brady., et al. 2024) enfatiza que la responsabilidad de la institución médica no termina en la compra; advierte explícitamente que los hospitales deben establecer mecanismos propios para monitorizar la estabilidad y seguridad de los algoritmos ante los cambios del entorno real.

El mensaje es unánime desde Norteamérica hasta Oceanía, el hospital moderno necesita equipos capaces de aplicar estos marcos globales para auditar a los proveedores, exigiendo transparencia y garantías de desempeño local antes, durante y después del despliegue.

De silos aislados a inteligencia colectiva

Para las instituciones que legítimamente poseen activos de datos diferenciados, el imperativo ético y científico no es el acaparamiento, sino la federación. La tecnología de aprendizaje federado emerge como el estándar de oro para la colaboración multicéntrica, permitiendo el entrenamiento colaborativo de algoritmos sin requerir la filtración de datos sensibles fuera de la infraestructura hospitalaria.

Este enfoque desacopla la capacidad de aprendizaje de la necesidad de centralización física, otorgando a los hospitales el control total sobre sus activos de información mientras se benefician de una inteligencia compartida de escala global. En este nuevo ecosistema, la excelencia no se mide por quién posee más datos, sino por quién colabora mejor. Los hospitales evolucionan de ser repositorios estáticos para convertirse en nodos dinámicos de una red neuronal distribuida, acelerando el descubrimiento científico con una velocidad y seguridad imposibles de lograr en aislamiento.

Conclusión

La verdadera innovación en salud digital no reside en la autoría del algoritmo, sino en la sabiduría de su implementación. Persistir en la ambición de convertir hospitales en fábricas de software es una distracción estratégica que diluye el capital y fragmenta el talento. El futuro no pertenece a las instituciones que compiten por escribir el código más complejo, sino a aquellas que, desde una gobernanza rigurosa, se especializan en auditar, orquestar y humanizar la inteligencia artificial. La ventaja competitiva final nunca será el modelo matemático; siempre será la confianza del paciente.

Palabras Clave: inteligencia artificial en hospitales, IA en salud digital, riesgos de IA en hospitales, costos de implementar IA en salud, gobernanza de IA en salud, validación de algoritmos médicos, deuda técnica oculta en IA, underspecification en modelos clínicos, Data Cascades en salud digital, sesgos algorítmicos en hospitales, dataset shift en IA médica, falacia estratégica IA hospitales, costo de desarrollo vs costo operativo IA, soberanía de datos en salud, hospital inteligente vs fábrica de software, product liability IA médica, caja negra en algoritmos clínicos, sesgo algorítmico y equidad en salud, guías ECLAIR radiología, validación multicéntrica IA, aprendizaje federado en salud, gobernanza de IA hospitalaria, aprendizaje federado.

Referencias bibliográficas

- Boston Consulting Group (BCG). (2018). The Build-or-Buy Dilemma in AI: Values, Scenarios, and Decision Matrix.

- Sculley, D., et al. (2015). «Hidden Technical Debt in Machine Learning Systems.» NeurIPS, 2, 2503–2511.

- American Hospital Association (AHA). (2025). Market Insights: AI Report 2025 – Building and Implementing an Artificial Intelligence Action Plan for Health Care.

- D’Amour, A., et al. (2022). «Underspecification Presents Challenges for Credibility in Modern Machine Learning.» Journal of Machine Learning Research.

- Sambasivan, N., et al. (2021). «Everyone wants to do the model work, not the data work: Data Cascades in High-Stakes AI.» CHI Proceedings.

- Wong, A., et al. (2021). «External Validation of a Widely Implemented Proprietary Sepsis Prediction Model in Hospitalized Patients.» JAMA Internal Medicine, 181(8), 1065–1070.

- Kamel Rahimi, A., et al. (2024). «Implementing AI in Hospitals to Achieve a Learning Health System: Systematic Review of Current Enablers and Barriers.» JMIR, 26:e49655.

- Gerke, S., Minssen, T., & Cohen, G. (2020). «Ethical and legal challenges of artificial intelligence-driven healthcare.» Artificial Intelligence in Healthcare, 295–336.

- Obermeyer, Z., et al. (2019). «Dissecting racial bias in an algorithm used to manage the health of populations.» Science, 366(6464), 447-453.

- Omoumi, P., et al. (2021). «To buy or not to buy—evaluating commercial AI solutions in radiology (the ECLAIR guidelines).» European Radiology, 31, 3786–3796.

- Brady, A. P., et al. (2024). «Developing, Purchasing, Implementing and Monitoring AI Tools in Radiology: Practical Considerations. A Multi-Society Statement.» Radiology: Artificial Intelligence, 6(1)

- Rieke, N., et al. (2020). «The future of digital health with federated learning.» Nature Digital Medicine, 3, 119.