Autor: Luis Carlos Quintero Malo M.D. Médico Especialista y Magister en Bioética – Miembro de AIpocrates

En principio la respuesta es SI, y a pesar de ser casi obvio les explicare porque la POLITICA es tan importante en el aporte científico y social.

En las últimas décadas, ha sido evidente el protagonismo de la Inteligencia Artificial (IA) en sectores como la economía, la salud, la educación; sin embargo, no se relaciona con política, porque lo entendemos como lejano. Pero ese rápido desarrollo o protagonismo plantea dilemas éticos que llevan a la necesidad de participación de la política, porque se evidencia la necesidad de marco regulatorio que permita el desarrollo: no es el freno, es el apoyo para el desarrollo, porque la idea es que se garantice el desarrollo tecnológico con una utilidad responsable, justa y transparente. A continuación, les cuento como estos tres ámbitos se entrelazan, analizando los desafíos actuales y las posibles soluciones desde una perspectiva crítica.

El primer ámbito por destacar es la política y gobernanza de la IA

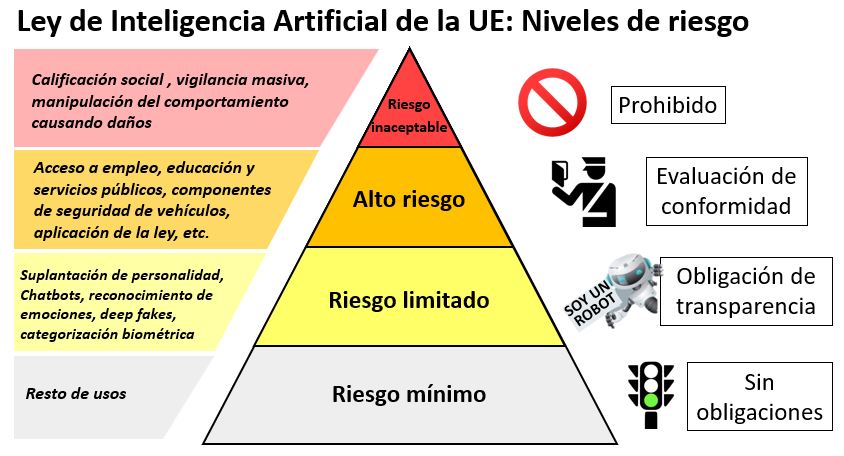

La política se vuelve el elemento regulador fundamental de la IA, y en la regulación de esta, los gobiernos y organismos; pues, establecen marcos normativos locales e internacionales que permiten abordar los riesgos asociados con su uso. Por ejemplo, la Unión Europea propuso el “Reglamento de Inteligencia Artificial (AI Act)” en 2021, que clasifica los sistemas de IA según su nivel de riesgo y establece prohibiciones para aplicaciones consideradas peligrosas, como el reconocimiento facial indiscriminado (European Commission, 2021).

Sin embargo, la regulación de la IA varía significativamente entre países, la falta de consenso internacional dificulta la creación de estándares globales, mientras que algunas naciones adoptan un enfoque restrictivo, otras promueven la innovación sin suficientes salvaguardas éticas. Esta divergencia genera tensiones geopolíticas, especialmente en la competencia entre Estados Unidos y China por la supremacía en IA (Lee, 2022) y un “vacío legal” que puede llevar a usos malintencionados, como la manipulación electoral mediante “deepfakes” o la vigilancia masiva.

El segundo ámbito es la Ética en el Desarrollo y Uso de la IA

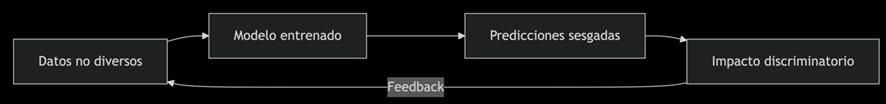

La ética en la IA se centra en principios como la transparencia, la equidad, la privacidad y la responsabilidad, siendo uno de los mayores desafíos el sesgo algorítmico, que surge porque los modelos de IA se entrenan con datos generados por humanos y, por tanto, pueden heredar y perpetuar prejuicios raciales, de género o socioeconómicos. Un estudio de Buolamwini y Gebru (2018) demostró que los sistemas de reconocimiento facial tienen tasas de error más altas en mujeres y personas de piel oscura, lo que refleja la falta de diversidad en los datos de entrenamiento. De ahí la importancia de disminuir al máximo la carga moral de las decisiones (de esto podemos hablar en otra ocasión); con otro dilema ético destacado es la “autonomía de las máquinas”.

¿Debe permitirse que sistemas de IA tomen decisiones en ámbitos críticos como la justicia o la medicina?

Aunque la automatización puede aumentar la eficiencia, también implica riesgos si no existe una supervisión humana adecuada. Un ejemplo es el uso de algoritmos predictivos en el sistema judicial de Estados Unidos, que ha sido criticado por reforzar prejuicios raciales (O’Neil, 2016). Sin embargo, el control humano tampoco está exento de sesgos, lo que genera una tensión compleja: Una espiral en la que los errores humanos y algorítmicos se refuerzan entre sí, acelerando la toma de decisiones, pero deteriorando la calidad por la ausencia de un análisis crítico.

¿Qué tipo de decisiones buscamos: rápidas y eficaces, profundamente humanas o una combinación de ambas? Este desarrollo es posible, pero requiere políticas que orienten el uso de la inteligencia artificial dentro de un marco regulatorio actualizado, flexible y dinámico, capaz de adaptarse y responder a las necesidades de un entorno que rápidamente cambiante.

A esto se suma la preocupación por la privacidad, amenazada por la recolección masiva de datos, un tema ya abordado por el Dr. Alejandro Hernández en un espacio anterior, lo cual se refleja en el uso que empresas como Meta y Google hacen de la inteligencia artificial para analizar el comportamiento de los usuarios. Esta práctica genera serias dudas sobre el consentimiento informado y el uso ético de la información personal (Zuboff, 2019).

Es importante destacar que los lenguajes de programación, los frameworks y las herramientas empleadas en el desarrollo de inteligencia artificial pueden influir en los sesgos y limitaciones de estos sistemas. Lenguajes como Python, R y Julia, junto con frameworks como TensorFlow, PyTorch y Scikit-learn, dominan actualmente este campo. Python, en particular, es el más utilizado debido a su sintaxis accesible y a su ecosistema de bibliotecas especializadas (van Rossum, 2021). Sin embargo, la elección del lenguaje y de las herramientas no es inocua, ya que cada uno introduce supuestos, restricciones y formas particulares de estructurar los datos y los modelos.

Sesgo en los Datos y los Algoritmos

- Muchos modelos de IA se entrenan con conjuntos de datos que reflejan desigualdades estructurales. Por ejemplo, sistemas de reconocimiento facial como OpenCV (escrito en C++, pero ampliamente usado con Python) han mostrado menor precisión en personas de piel oscura debido a la falta de diversidad en los datos (Buolamwini & Gebru, 2018).

- Frameworks como TensorFlow permiten implementar redes neuronales complejas, pero si los desarrolladores no auditan los datos de entrada, los sesgos se perpetúan.

Transparencia y Explicabilidad

- Lenguajes como Python facilitan la implementación de modelos, pero no garantizan que estos sean interpretables. Herramientas como SHAP (SHapley Additive exPlanations) y LIME intentan hacer los modelos más explicables, pero su efectividad depende de cómo se integren en el flujo de desarrollo (Ribeiro et al., 2016).

- En contraste, lenguajes como Prolog (usado en sistemas basados en reglas) permiten mayor transparencia en la toma de decisiones, pero su uso en IA moderna es limitado.

Y el tercero es la dirección hacia una Gobernanza Ética y Democrática de la IA

Para equilibrar innovación y protección de derechos, se requiere una gobernanza que involucre a gobiernos, empresas, sociedad civil y académicos multidisciplinaria,

la idea es tener y generar el balance de riesgos y beneficios para que se lo más equilibrado posible.

Algunas propuestas incluyen:

- Regulaciones basadas en derechos humanos: Las políticas de IA deben alinearse con estándares internacionales como el GDPR (Reglamento General de Protección de Datos) en Europa, aunque no todos están convencidos que los derechos humanos deben regir todas las políticas porque podrían ser limitantes en el progreso.

- Regulación y Estándares Técnicos: La UE, en su AI Act (2021), exige transparencia en sistemas de alto riesgo. Esto implica que las empresas deben documentar no solo los datos, sino también las herramientas y lenguajes usados en el desarrollo. Sin embargo, no hay un estándar único: ¿debería exigirse el uso de lenguajes con mejores prácticas de auditoría algorítmica?

- Desigualdad Tecnológica: El dominio de Python y TensorFlow en IA concentra el conocimiento en comunidades angloparlantes y en países con mayor acceso a educación tecnológica. Esto excluye a regiones con menos recursos, perpetuando desigualdades globales (Crawford, 2021).

¿Deberían promoverse alternativas open-source en otros idiomas o con menor barrera de entrada?

- Auditorías algorítmicas:

- Una estrategia clave es implementar evaluaciones independientes que permitan detectar sesgos y garantizar la transparencia de los sistemas de inteligencia artificial (Raji et al., 2020). Estas auditorías abren una pregunta importante relacionada con la espiral de retroalimentación entre humanos y algoritmos: ¿queremos que los sistemas reproduzcan nuestras expectativas o que generen resultados genuinamente nuevos?

- En este contexto, surge la propuesta de incorporar ética en el código, es decir, integrar principios éticos directamente en el desarrollo del software mediante “lenguajes éticos” o bibliotecas diseñadas para evitar comportamientos discriminatorios de forma automática (Veale et al., 2018). Un ejemplo es AI Fairness 360 de IBM, una herramienta desarrollada en Python que permite identificar y mitigar sesgos en modelos de aprendizaje automático, aunque su adopción en la práctica aún es limitada.

Propuestas desde la Ingeniería y la Política donde refiere que se necesitan acciones conjuntas entre tecnólogos y reguladores:

Diversificación de Herramientas:

Fomentar el uso de lenguajes y frameworks que prioricen la transparencia (ej: Rust para sistemas críticos, o “Julia” para análisis reproducible).

- Auditorías Obligatorias de Código:

Legislaciones como el “AI Act” podrían requerir revisiones independientes no solo de los datos, sino del código fuente en sectores sensibles (salud, justicia).

- Educación pública:

Fomentar la alfabetización digital para que los ciudadanos comprendan los riesgos y beneficios de la IA.

Formación de programadores con módulos educativos de Ética Computacional, sesgos algorítmicos y regulaciones que permitan más equidad.

Enseñanza equitativa y usos de Python, R y otros lenguajes relevantes, con ejemplos prácticos.

La UNESCO ha publicado recomendaciones éticas para la IA, destacando la necesidad de inclusión y sostenibilidad (UNESCO, 2021). Sin embargo, sin mecanismos de aplicación efectivos, estas guías pueden quedar en declaraciones simbólicas.

La realización de actividades de investigación, en conjunto con la educación y el desarrollo institucional, constituye un aporte fundamental para la formulación de políticas, como lo evidencia el gráfico a continuación.

Conclusión

La interacción entre política, ética e IA es compleja pero esencial para un futuro tecnológico justo. Mientras la política establece las reglas del juego, la ética asegura que el desarrollo tecnológico no sacrifique valores humanos fundamentales. Aunque existen avances en regulaciones y principios éticos, persisten desafíos como el sesgo algorítmico, la privacidad y la falta de cooperación internacional, donde mientras Python y TensorFlow dominan el campo, su uso sin críticas puede reforzar desigualdades. La armonización de este conflicto requiere un enfoque colaborativo que priorice el bien común sobre intereses económicos o geopolíticos. Solo así la IA podrá ser una herramienta de progreso y no de inequidad.

Una gobernanza efectiva de la IA debe considerar no solo las leyes, sino también los aspectos técnicos del desarrollo, promoviendo diversidad, transparencia y justicia algorítmica desde el código fuente.

Bibliografía

– Buolamwini, J., & Gebru, T. (2018). *Gender Shades: Intersectional Accuracy Disparities in Commercial Gender Classification*. Proceedings of Machine Learning Research.

– European Commission. (2021). *Proposal for a Regulation on Artificial Intelligence*. Bruselas.

– Lee, K. (2022). *AI Superpowers: China, Silicon Valley, and the New World Order*. Houghton Mifflin Harcourt.

– O’Neil, C. (2016). *Weapons of Math Destruction: How Big Data Increases Inequality and Threatens Democracy*. Crown Publishing.

– Raji, I. D., et al. (2020). *Closing the AI Accountability Gap: Defining an End-to-End Framework for Internal Algorithmic Auditing*. ACM Conference on Fairness, Accountability, and Transparency.

– UNESCO. (2021). *Recommendation on the Ethics of Artificial Intelligence*.

– Zuboff, S. (2019). *The Age of Surveillance Capitalism: The Fight for a Human Future at the New Frontier of Power*. PublicAffairs.

– Buolamwini, J., & Gebru, T. (2018). Gender Shades: Intersectional Accuracy Disparities in Commercial Gender Classification. Conference on Fairness, Accountability, and Transparency.

– Crawford, K. (2021). Atlas of AI: Power, Politics, and the Planetary Costs of Artificial Intelligence. Yale University Press.

– European Commission. (2021). Proposal for a Regulation on Artificial Intelligence (AI Act).

– Ribeiro, M. T., et al. (2016). «Why Should I Trust You?»: Explaining the Predictions of Any Classifier. ACM SIGKDD.

– Veale, M., et al. (2018). Fairness and Accountability Design Needs for Algorithmic Support in High-Stakes Public Sector Decision-Making. ACM Conference on Human Factors in Computing Systems.

– van Rossum, G. (2021). The Python Language Reference. Python Software Foundation.