Luis Eduardo Pino V. MD, M.Sc, MBA. Fundador de AIpocrates, Fundador y CEO OxLER

Resumen

Esta columna introduce el concepto de Medicina Generativa en Oncología, enfatizando en el impacto revolucionario de la Inteligencia Artificial Generativa (IAGen) más allá de las capacidades conversacionales de ChatGPT. Explora cómo la IA puede analizar grandes cantidades de datos clínicos para producir diagnósticos precisos, pronósticos personalizados y opciones de tratamiento optimizadas. El texto destaca el potencial de la tecnología en el desarrollo de fármacos e investigación biomédica, delineando su capacidad para identificar nuevas moléculas farmacéuticas y predecir la eficacia del tratamiento. La discusión se extiende a los desafíos y oportunidades de implementar la IAGen en oncología, incluyendo consideraciones éticas, la necesidad de validación clínica y la promesa de mejorar los resultados de los pacientes mediante la colaboración multidisciplinaria.

Si se pudiera reducir la toma de decisiones humanas a un solo concepto, sería al de «reconocimiento de patrones». En la cognición médica, nuestro modelo mental nos lleva a dos procesos críticos como son la recuperación y activación del conocimiento y la asignación de guiones de enfermedad. Nuestras mentes constantemente producen diagramas y simulaciones a pequeña escala de cómo funciona la naturaleza para compensar la falta de capacidad de procesamiento de nuestros cerebros, a esto le llamamos “modelos”. Por ejemplo, para conducir un automóvil, no necesitamos entender su funcionamiento interno, sino algunos conceptos simples, o «nodos», necesarios para completar una tarea específica, en este caso, transportarnos del punto A al punto B. Algunos «nodos» podrían ser las ruedas, el volante, el motor, el combustible. Una vez identificados los nodos, necesitamos conectarlos y entender cómo se relacionan entre sí.

Una línea de pensamiento podría ser la siguiente: el automóvil tiene un motor, y el motor necesita combustible para producir energía, y esa energía se transferirá a las ruedas; con el volante, puedo controlar los movimientos del automóvil. Si puedo controlar cómo se mueve el automóvil, puedo llegar a una ubicación determinada. Ahora podemos añadir dos nodos más, el pedal del acelerador y el pedal del freno. Si presiono el pedal del acelerador, el automóvil se moverá; si presiono el pedal del freno, se detendrá. Al conocer los nodos y su relación, nuestra mente produce algunas simulaciones interesantes con el propósito de tomar una decisión.

Nuestra incapacidad como humanos para vincular las decisiones con la mejor evidencia se debe en parte a nuestras limitaciones cognitivas. En 1950 se estimó que la memoria a corto plazo o la memoria de trabajo humana estaba limitada a 762 variables, una estimación más actual es la de 461 constructos. Pero la calidad de la decisión generalmente se degrada una vez se supera este límite de cuatro constructos. Debido a esta limitación, la mayoría de las decisiones clínicas se basan en una a tres variables. Esta limitación nos permite desarrollar reglas racionales para la toma de decisiones, porque cada decisión se basa en tan pocas variables de entrada, pero el límite de cuatro constructos parece sorprendente para los humanos, que comúnmente sobreestimamos nuestro rendimiento.1

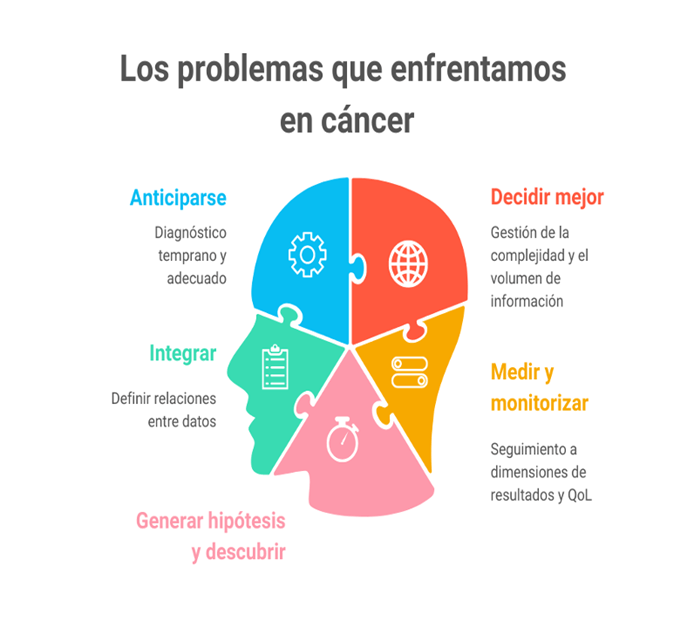

En Oncología tenemos diversos retos y desafíos ya que somos una de las especialidades que deben gestionar de forma profunda a la complejidad y la incertidumbre para la toma de decisiones, en un entorno de cambios rápidos de la evidencia y de grandes volúmenes de información. Enfrentar dichos problemas únicamente con las herramientas dadas por la inteligencia natural, las cuales como se deduce son limitadas, es imposible.

Las grandes disrupciones marcan momentos de la historia que nunca olvidaremos, algunos por su impacto masivo como los ataques del 11 de septiembre de 2001, los cuales redefinieron el terrorismo mundial y trazaron un nuevo rumbo geopolítico, otros derivados de ideas que han cambiado el mundo como el descubrimiento del fuego, la invención del cálculo o la internet.

En noviembre de 2022 la aparición del desarrollo informático llamado chatGPT desarrollado por la empresa OpenAI trajo a la luz un nuevo concepto: la Inteligencia Artificial Generativa (IAGen). Actualmente ese concepto pasó de ser una nueva ficha en el ajedrez de la Inteligencia Artificial (IA) a tomar las riendas de la evolución hacia una IA general global que abarque diversas capacidades en todos los sectores, incluyendo por supuesto al de la salud.

Introducción a la Medicina Generativa

Solicito al lector no confundir este término con el de medicina regenerativa que tiene un contexto enfocado en el uso de tecnologías celulares para la reparación, regeneración y reemplazo de tejidos y órganos dañados o enfermos.

La Inteligencia Artificial Generativa ha abierto nuevas posibilidades en el campo de la medicina, trascendiendo el ámbito de las conversaciones automatizadas de ChatGPT. Estos avances tecnológicos están revolucionando la forma en que se abordan los desafíos médicos, permitiendo a los profesionales de la salud explorar y desarrollar soluciones innovadoras y personalizadas, pero además fungiendo como asistentes cognitivos para una mejor toma de decisiones.

La IA generativa en medicina se basa en la capacidad de los modelos de IA para aprender de grandes cantidades de datos y generar contenido que no necesariamente se parece a sus datos de entrenamiento, es decir uno nuevo y valioso en el contexto médico. Estos modelos pueden analizar y comprender información clínica, investigaciones científicas, historiales médicos y otros datos relevantes para proporcionar diagnósticos más precisos, pronósticos personalizados y opciones de tratamiento optimizadas.

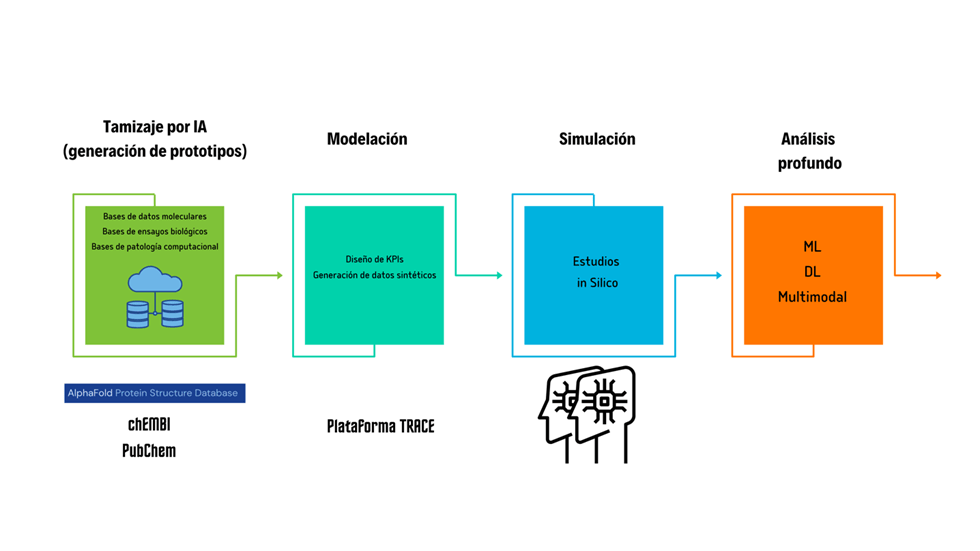

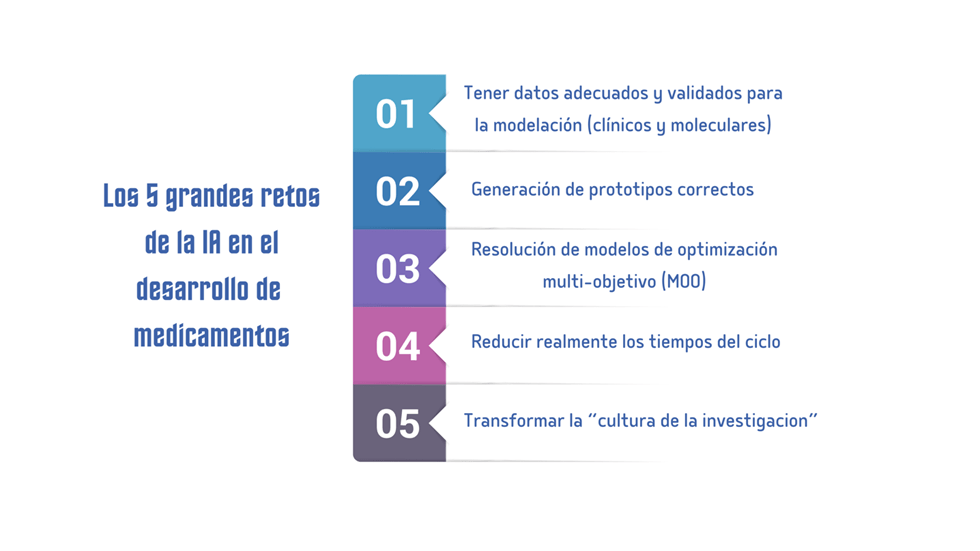

A medida que la tecnología avanza, la medicina generativa también se está utilizando para mejorar la investigación biomédica y el desarrollo de medicamentos. Los modelos de IA pueden ayudar en la identificación de nuevas moléculas farmacéuticas, predecir la eficacia de ciertos tratamientos y acelerar el proceso de descubrimiento de diversas tecnologías.

Los gráficos resumen los puntos en donde la IAGen podría impactar en el desarrollo actual y futuro de medicamentos, pero también las serias limitaciones por superar.

El propósito de esta columna es el de ofrecer al lector un conocimiento superior al concepto de las conversaciones con modelos como ChatGPT como usuarios, allanando el camino hacia una medicina más precisa, personalizada y eficiente. Se abordarán los conceptos técnicos aplicados de la IAGen, sus avances más recientes, las aplicaciones prácticas y las perspectivas futuras de esta fascinante convergencia entre ella y la medicina, en este caso la oncología.

¿Por Qué IA Generativa?

El campo de la inteligencia artificial generativa ha estado evolucionando rápidamente en los últimos años, con varios actores importantes en la industria y la comunidad de código abierto, liderando el camino en la realización de grandes avances. Estos avances han dado lugar a nuevas posibilidades y aplicaciones para la misma, como en los campos del procesamiento del lenguaje natural (NLP), la visión por computadora y la generación de música. Además, la creciente disponibilidad de datos y potencia de cálculo ha permitido desarrollar modelos más complejos y sofisticados, lo que abre aún más el potencial para la inteligencia artificial generativa en el futuro. A medida que este campo continúe creciendo y desarrollándose, será emocionante ver qué nuevos avances surgirán y cómo darán forma a nuestro mundo.

Hoy tenemos dos grandes campos de la IA: la IA Analítica o clásica, esta se refiere al uso de máquinas para analizar datos existentes e identificar patrones o hacer predicciones para diversas aplicaciones como detección de fraudes o recomendaciones de contenido, esto a través de sus diversos tipos de entrenamiento (supervisado, no supervisado, reforzado, semisupervisado). Es decir, se centra en analizar y procesar la información disponible. Por otro lado, la IA Generativa es un campo que implica que las máquinas generen nuevos datos, como imágenes, texto o música, basados en patrones y modelos aprendidos. Para facilitar la comprensión veamos algunos ejemplos:

- IA clásica: Supongamos que tenemos un conjunto de datos de transacciones financieras del sistema de salud. Utilizando algoritmos de IA analítica podemos analizar esos datos para identificar patrones y detectar anomalías que puedan indicar actividades fraudulentas o extremos. Esto puede ayudar al sistema de salud a encontrar posibles fraudes y tomar medidas preventivas.

- IA Generativa: Si entrenamos a un modelo de IA generativa con millones de estructuras proteicas como AlphaFold3 y posteriormente le introducimos instrucciones (o prompts, en adelante) podríamos generar modelos sintéticos de moléculas de diversa índole para su posterior desarrollo.

La inteligencia artificial generativa no es nueva, ha estado en desarrollo durante algún tiempo, pero en los últimos años, todo el ecosistema de la IA generativa ha experimentado un desarrollo significativo. Sin embargo, para comprender completamente el estado actual de los acontecimientos y apreciar el potencial completo de la IA generativa, es importante adentrarse en los avances realizados en el campo del procesamiento del lenguaje natural (NLP). El surgimiento de los modelos transformadores o Transformers desempeñó un papel crucial en este sentido. 2 A través del uso de transformadores, la IA ahora puede procesar y generar lenguaje, imágenes y videos, y trabajar en múltiples modalidades combinadas. 2

Procesamiento de Lenguaje Natural, ¿cómo así?

El procesamiento de lenguaje natural (NLP) es una rama de la inteligencia artificial que se ocupa de la interacción entre las computadoras y el lenguaje humano. Su objetivo es permitir que las computadoras comprendan, analicen y generen lenguaje humano de manera efectiva.

El lenguaje humano es complejo y diverso, y el NLP abarca una amplia gama de tareas para procesar y comprender el lenguaje. Algunas de estas tareas incluyen entre otros:

- Tokenización: Dividir el texto en unidades más pequeñas, como palabras o subpalabras, para su análisis posterior. El texto y las imágenes son susceptibles de transformarse en estructuras matemáticas para poderlas introducir a los lenguajes de programación.

- Análisis morfológico: Identificar la estructura y forma de las palabras, incluyendo raíces, prefijos y sufijos.

- Análisis sintáctico: Determinar la estructura gramatical de una oración y las relaciones entre las palabras.

- Análisis semántico: Comprender el significado de las oraciones y las palabras, incluyendo la interpretación de la intención y el contexto.

- Desambiguación: Resolver ambigüedades en el lenguaje, como la polisemia (palabras con múltiples significados) y la correferencia (referencia a entidades previamente mencionadas).

- Generación de lenguaje natural: Crear texto coherente y comprensible para comunicarse con los usuarios.

El NLP se aplica en una amplia variedad de campos como traducción automática, análisis de sentimientos, chatbots, asistentes virtuales, resumen automático de texto, extracción de información, clasificación de texto y muchas más. Gracias al NLP tenemos hoy algunas historias clínicas electrónicas que anticipan texto y automatizan registros. 3

Para resolver eficazmente los problemas en el espacio de NLP, existen diversos desafíos:

- Complejidad del Lenguaje Natural: El lenguaje humano es sutil, ambiguo y dependiente del contexto. Por lo tanto, plantea un desafío significativo para los modelos de aprendizaje automático para comprender y generar texto coherente y significativo.

- Problema de Dependencia Larga: En muchos casos, el significado de una oración o una frase depende en gran medida del contexto establecido mucho antes en el texto. Los modelos de NLP tradicionales tienen dificultades para mantener y comprender estas dependencias a largo plazo. Los nuevos modelos de estados de espacio selectivo (SSM) parecen estar solucionando este inconveniente. 4

- Escalabilidad: El procesamiento de texto a gran escala requiere recursos computacionales significativos, lo que dificulta escalar los sistemas de NLP tradicionales para tareas más grandes.

- Falta de Generalización: A menudo, los modelos tienen dificultades para generalizar su comprensión del lenguaje en diferentes tareas, géneros e idiomas.

- Limitación de los modelos RNN y LSTM: Durante mucho tiempo se utilizaron modelos de Deep learning como las Redes Neuronales Recurrentes (RNN) y los modelos de Memoria a Corto y Largo Plazo (LSTM), que alguna vez fueron fundamentales para las tareas de NLP, pero tienen limitaciones, especialmente su procesamiento secuencial, alto recurso computacional, gradiente desvaneciente etc, que limitan el análisis de las dependencias mencionadas previamente y hacen difícil la adaptación a la computación paralela, es decir a usar recursos modernos de hardware.

En el año 2017 apareció una nueva arquitectura informática que -como su nombre lo indica- transformó el mundo de NLP, esta fue la de los Transformadores que se detallarán en la siguiente columna…