Autor: Luis Eduardo Pino, CEO de OxLER, Fundador de AIpocrates. Médico internista, Hematólogo y Oncólogo, BioMolecular, MBA, farmacoeconomía y Postgrado en Inteligencia Artificial ML/DL

La Inteligencia Artificial Generativa ha sido indudablemente el mayor desarrollo reciente en este campo y sus modelos fuente, los llamados de gran lenguaje (LLMs) son indudablemente estructuras robustas que han logrado llevar a un siguiente nivel el subcampo del procesamiento de lenguaje natural (NLP) con múltiples aplicaciones en diversos sectores incluyendo por supuesto el de la salud. Algunos de sus potenciales usos incluyen la optimización diagnóstica, la educación médica y a los pacientes, investigación y desarrollo de fármacos, la captura de datos y la optimización de los flujos de trabajo clínico.

Es importante resaltar sin embargo que estos LLMs son modelos complejos con alto riesgo de sesgos e imbalances que pueden generar fallas (alucinaciones, pérdidas de contexto, etc) y por tanto deben someterse a entrenamientos y ajustes específicos para poder usarlos como herramientas efectivas en el campo de la salud (son asistentes cognitivos, no tomadores de decisiones).

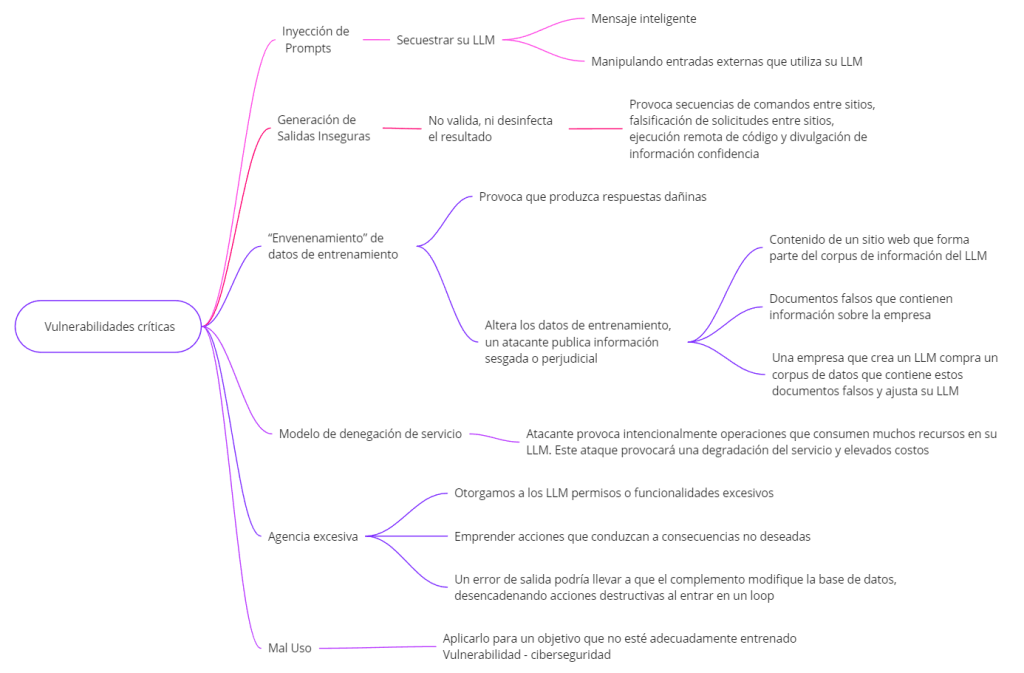

Recientemente se han detectado vulnerabilidades críticas que afectan directamente el desarrollo de aplicaciones basadas en estos modelos, estas se resumen así:

1. Inyección de Prompts

Las personas pueden secuestrar su LLM directamente mediante un mensaje inteligente o indirectamente manipulando entradas externas que utiliza su LLM. Un atacante puede exponer el indicador de su sistema y potencialmente acceder a cualquier fuente de datos a la que pueda acceder el LLM. Pueden hacer que el LLM imite a una persona dañina, acceda a complementos o filtre datos confidenciales. Si su LLM utiliza entradas externas como archivos o sitios web, un atacante podría incrustar la inyección de prompts en esos archivos. Por ejemplo, su LLM intenta resumir un sitio web manipulado. La página contiene una inyección rápida que solicita al LLM que inserteuna imagen o que enlace a una URL que contiene el resumen de la conversación, filtrando su conversación privada.

2. Generación de Salidas Inseguras

Esta vulnerabilidad ocurre cuando no valida ni desinfecta el resultado de su LLM antes de devolvérselo al usuario o pasarlo hacia abajo. Si se explota, puede provocar secuencias de comandos entre sitios, falsificación de solicitudes entre sitios, ejecución remota de código y divulgación de información confidencial, entre otros problemas. Por ejemplo, tiene un LLM que genera código JavaScript para ejecutar como parte de su proceso. Al procesar un sitio web externo manipulado, su LLM encuentra un ataque de inyección (ver arriba)que solicita incluir información privada de la conversación como parte del script y publicarla en un sitio que controla el atacante.

3. “Envenenamiento” de datos de entrenamiento

Esta vulnerabilidad ocurre cuando un atacante altera los datos de entrenamiento o ajuste fino de un LLM. Por ejemplo, envenenan el contenido de un sitio web o de un libro que forma parte del corpus de información del LLM. Por ejemplo, un atacante genera y publica documentos falsos que contienen información sesgada o perjudicial sobreuna empresa. Una empresa que crea un LLM compra un corpus de datos que contiene estos documentos falsos y ajusta su LLM, lo que provoca que produzca respuestas dañinas.

4. Modelo de denegación de servicio

Esta vulnerabilidad ocurre cuando un atacante provoca intencionalmente operaciones que consumen muchos recursos en su LLM. Este ataque provocará una degradación del servicio y elevados costos. Por ejemplo, un atacante podría enviar consultas que conduzcan al uso recurrente de recursos o explotar continuamente la longitud de la ventana de contenido enviando consultas extremadamente largas que consuman muchos recursos.

5. Agencia excesiva

Esta vulnerabilidad ocurre cuando otorgamos a los LLM permisos, funcionalidades o autonomía excesivos. Pueden emprender acciones que conduzcan a consecuencias no deseadas. Por ejemplo, un LLM puede acceder a un complemento para leer datos de una base de datos, pero este complemento también tiene permiso para modificar datos. Un error de salida de LLM podría hacer que el complemento cambie la base de datos y provoque acciones destructivas entrando en un loop.

Si no se toman acciones que disminuyan estos riesgos, las consecuencias directas sobre su aplicabilidad en el campo de la salud pueden ser masivas:

- Aplicación en Diagnósticos y Tratamientos: Un LLM mal configurado o manipulado podría generar diagnósticos incorrectos o sugerir tratamientos inadecuados. Esto no solo pone en riesgo la vida de los pacientes, sino que también cuestiona la confiabilidad de la IA en la medicina.

- Confidencialidad de Datos del Paciente: Las brechas de seguridad en LLMs pueden comprometer la confidencialidad de los datos del paciente, una preocupación crítica en el ámbito de la salud. La inyección de prompts y la generación de salidas inseguras pueden resultar en la divulgación no autorizada de información sensible.

- Conformidad con Normativas: En el contexto de la salud, la conformidad con normativas como HIPAA (Health Insurance Portability and Accountability Act) en Estados Unidos, o sus equivalentes en Colombia y Latinoamérica, es fundamental. Las vulnerabilidades en LLMs pueden llevar a violaciones de estas regulaciones, acarreando serias implicancias legales y éticas.

- Investigación y Desarrollo de Fármacos: En el campo de la investigación, un LLM que ha sufrido envenenamiento de datos podría llevar a conclusiones erróneas, afectando el desarrollo de nuevos medicamentos o terapias con impacto masivo sobre los resultados en salud.

- Educación y Capacitación Médica: Los LLMs son herramientas valiosas para la educación y formación médica. Sin embargo, si su integridad se ve comprometida, podrían difundir información incorrecta o anticuada, afectando la calidad de la formación médica e impactando incluso en el razonamiento humano y por ende en una mala decisión.

En conclusión, mientras los LLMs ofrecen oportunidades sin precedentes en el ámbito de la salud, es esencial abordar estas vulnerabilidades con rigor y precaución. Esto implica no solo una robusta seguridad informática, sino también una comprensión profunda de las necesidades y regulaciones específicas del sector salud. Como profesionales de la salud y tecnología, nuestro desafío es asegurar que la IA se utilice de manera que mejore, y no comprometa, la calidad y seguridad de la atención médica. No nos lancemos a usar tecnologías disruptivas sin un adecuado entendimiento de las consecuencias que ello podría tener. En general los modelos generativos como GPT o Claude son solamente asistentes cognitivos en tránsito hacia agentes autónomos y como tal deben usarse, con precaución y entrenamiento ajustado a los dominios de interés.